Die klaren Worte des ehemaligen Leiters der KI-Sicherheit bei OpenAI, Jan Leike, haben eines sehr deutlich gemacht: Wir können uns nicht darauf verlassen, dass OpenAI und andere von selbst dafür sorgen, dass ihre Produkte sicher sind. Das ist nicht sonderlich überraschend, denn in anderen Industrien ist es ja ähnlich. So betreibt die Ölindustrie weiterhin massives Lobbying gegen Umweltschutzauflagen und die Automobilindustrie hat sich in den Achtzigerjahren mit Händen und Füßen gegen die Einführung von Airbags gewehrt. Auch die jüngsten Vorfälle bei Boeing zeigen, dass Top-Manager die Sicherheit ihrer Produkte oft nicht ernst genug nehmen. Sicherheit kostet Geld, und das will man am liebsten einsparen und an die Aktionäre ausschütten. Außerdem verlangsamt ein vorsichtiges Vorgehen die Entwicklung und führt zu einem Wettbewerbsnachteil, wenn die anderen mehr Risiken in Kauf nehmen. Im Wettrennen um Marktanteile gewinnt häufig der, dem Sicherheit am wenigsten wichtig ist.

Allerdings riskiert OpenAI womöglich nicht "nur" ein paar tödliche Autounfälle oder Flugzeugabstürze, sondern die Zukunft der ganzen Menschheit. Was können, was müssen wir unter diesen Umständen tun, um das Risiko einer potenziell unkontrollierbaren KI einzudämmen?

Solange wir nicht wissen, wie wir eine allgemeine KI auf übermenschlichem Niveau sicher kontrollieren können, gibt es nur eine Lösung: Wir dürfen eine solche KI nicht entwickeln. Zum Glück ist das zumindest bis heute noch niemandem gelungen und es ist auch nicht gerade einfach. Manche glauben immer noch, dass das frühestens in mehreren Jahrzehnten geschehen wird. Ich hoffe, dass diese Skeptiker recht behalten. Doch darauf verlassen können und dürfen wir uns nicht, KI entwickelt sich dafür viel zu rasant weiter. Wann der kritische Punkt erreicht wird, an dem wir die Kontrolle verlieren, wenn wir so weitermachen wie bisher, kann niemand seriös vorhersagen. Denn wir verstehen ja nicht einmal genau, wie heutige KI funktioniert und wozu sie fähig ist.

Dafür zu sorgen, dass etwas nicht entwickelt wird, ist schwierig, aber nicht unmöglich. So haben wir zum Beispiel bisher davon Abstand genommen, Menschen zu klonen. In Deutschland haben wir die Entscheidung getroffen, auf Atomenergie vollständig zu verzichten. Man kann darüber streiten, ob die Entscheidung richtig war, aber sie zeigt, dass es möglich ist, Technologien nicht zu nutzen, auch wenn man es könnte.

Damit eine solche Entscheidung getroffen werden kann, müssen eine Reihe von Voraussetzungen erfüllt sein:

- Es muss ein allgemeines Problembewusstsein geben.

- Es muss einen breiten gesellschaftlichen Konsens geben, dass eine bestimmte Technologie nicht genutzt werden soll.

- Es muss klar definiert sein, was genau nicht getan werden darf.

- Es muss die Möglichkeit geben, dies zu verbieten und ein Verbot auch durchzusetzen.

Momentan scheitern wir zumindest in Deutschland schon am ersten Punkt. Immer noch nimmt hierzulande kaum jemand die existenziellen Risiken der KI ernst, obwohl die führenden KI-Wissenschaftler mehrfach darauf hingewiesen haben. Stattdessen wird immer wieder behauptet, Warnungen vor den existenziellen Gefahren der KI seien bloß Hype oder ein Trick, um die Aufmerksamkeit von anderen, konkreteren Gefahren wie z.B. Benachteiligung von Minderheiten durch KI abzulenken. Deshalb brauchen wir dringend gerade hierzulande mehr Forschung zu den leider sehr realen existenziellen Risiken der KI.

Sofern die Gefahr allgemein erkannt ist, sollte ein gesellschaftlicher Konsens dazu nicht allzu schwierig zu erreichen sein. Bereits heute zeigen Befragungen, dass die überwiegende Mehrheit der „normalen Leute“ es für eine schlechte Idee hält, eine KI auf übermenschlichem Niveau zu entwickeln. Auch ohne die zahllosen mahnenden Beispiele in Science-Fiction-Filmen und -Romanen ist es intuitiv einleuchtend, dass es schwierig wird, etwas zu kontrollieren, das intelligenter ist als man selbst. Und der Blick aus dem Fenster zeigt, dass die intelligenteste Spezies bestimmt, wie es auf der Erde aussieht, und nicht die zweitintelligenteste (zum Leidwesen der Schimpansen und Gorillas). Wenn genügend Leute ihre Stimme erheben, wird ähnlich wie beim Klimawandel irgendwann der Druck auf die Politik groß genug, sich des Themas anzunehmen. Allerdings reagiert Politik recht langsam, deshalb bleibt uns vermutlich nicht mehr viel Zeit, um diesen Druck aufzubauen.

Der dritte Punkt ist vielleicht der schwierigste. KI ist wie alle Technologien ein zweischneidiges Schwert. Sie bietet viele Chancen, birgt aber auch extreme Risiken. Deshalb müssen wir ganz genau hinschauen, was wir gefahrlos tun können und was nicht. Dafür brauchen wir dringend mehr Forschung, um „rote Linien“ zu definieren, die nicht überschritten werden dürfen.

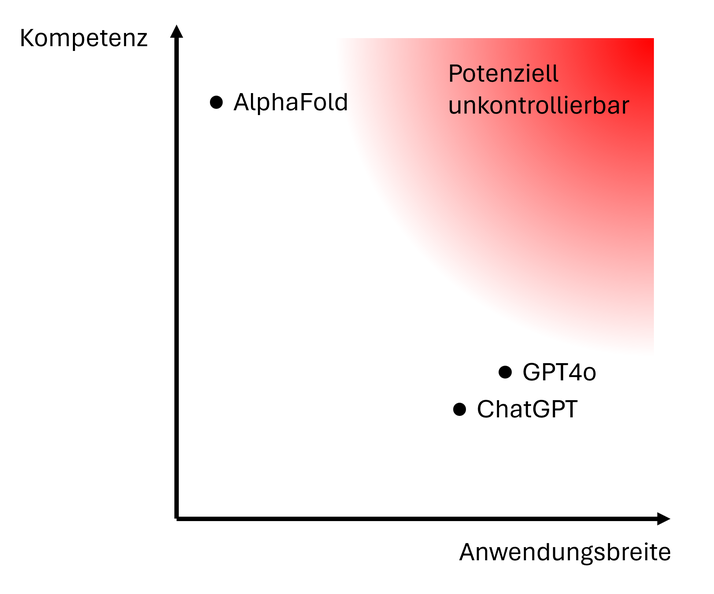

Ganz allgemein kann man sagen, dass eine sehr kompetente, aber hoch spezialisierte KI – z.B. eine Schach-KI oder ein System wie AlphaFold, das die Struktur von komplexen Molekülen vorhersagen kann – wohl kaum außer Kontrolle geraten wird. Ebenso stellt eine relativ inkompetente allgemeine KI wie etwa ChatGPT, die nur ein sehr unvollständiges Bild der Welt hat, keine existenzielle Bedrohung dar. Gefährlich wird es jedoch, wenn hohe Kompetenz in einem sehr breiten Anwendungsspektrum auftritt, so wie es bei uns Menschen der Fall ist. Eine solche KI könnte ihr breites Wissen und ihr Verständnis der Welt nutzen, um uns zu manipulieren und ihr wie auch immer definiertes Ziel ohne Rücksicht auf die Nebenwirkungen zu verfolgen. Dieses Szenario beschreibe ich z.B. in meinem Roman Virtua.

Sofern wir Punkt 3 erfüllt und rote Linien definiert haben, müssen diese durchgesetzt werden. Dies ist zumindest heute noch einfacher, als es im ersten Moment erscheinen mag. Denn um eine allgemeine KI auf menschlichem Niveau zu entwickeln, braucht man sehr viel Geld und Rechenleistung. Professionelle Investoren werden aber ihr Geld nicht in illegale Aktivitäten stecken und den Zugriff auf die für das Training der KI benötigten Computerressourcen kann man begrenzen. Es gibt zudem aktuell weltweit nur eine einzige Firma, die die benötigten Maschinen bauen kann, um hochentwickelte Computerchips herzustellen. Dies wird vermutlich nicht immer so bleiben – mit weiterem technischen Fortschritt könnte es irgendwann sehr viel einfacher sein, eine superintelligente KI zu entwickeln. Aber zumindest würden wir so Zeit gewinnen, um das knifflige Kontrollproblem vielleicht ein Stück weit zu lösen und/oder ein so gutes Verständnis der Gefahren zu erlangen, dass diejenigen, die in der Lage sind, eine superintelligente KI zu entwickeln, das aus Vernunftsgründen nicht tun.

Es gibt keine Garantie, dass wir in der Lage sein werden, rechtzeitig die vier nötigen Voraussetzungen zu schaffen, um die Entwicklung einer hoch gefährlichen, potenziell unkontrollierbaren KI zu verhindern oder wenigstens deutlich hinauszuzögern. Aber es ist garantiert, dass wir das nicht schaffen werden, wenn wir es nicht wenigstens versuchen.

Kommentar schreiben

Heinrich (Montag, 20 Mai 2024 19:29)

Ich kann nur eines tun, Deine Artikel allen empfehlen, die ich kenne.

Ich selbst könnte die Gefahr niemals so fundiert beschreiben.

Aber ich stoße immer wieder auf Desinteresse bis Ignoranz.

Die Menschen habe es scheinbar nicht besser verdient.

Vielen genügt es schon, wenn eine KI im Handy dafür sorgt, dass sie nicht gegen eine Laterne laufen, beim permanenten Blick auf's Display. ;)

Karl Olsberg (Dienstag, 21 Mai 2024 11:24)

Nicht aufgeben, Heinrich! Ich bin auch oft verzweifelt, aber steter Tropfen höhlt den Stein. Je mehr Menschen von dem Thema schon mal gehört haben, umso eher können wir die dringend notwendige breite gesellschaftliche Diskussion anstoßen. Dass mein vorgestern veröffentlichtes YouTube-Video über 6.000 Menschen erreicht, hat mich z.B. positiv überrascht. Vielleicht wacht die Welt ja doch noch rechtzeitig auf. Und wenn nicht, haben wir es wenigstens versucht.

Heinrich (Dienstag, 21 Mai 2024 13:20)

Ja, über Zugriffe und Kommentare habe ich mich auch gefreut. :)

Matthias (Mittwoch, 22 Mai 2024 08:23)

Sorry, aber diese ewig gleiche Panikmache nervt einfach nur.

Du schreibst "Dafür zu sorgen, dass etwas nicht entwickelt wird, ist schwierig, aber nicht unmöglich. So haben wir zum Beispiel bisher davon Abstand genommen, Menschen zu klonen..." und gehst scheinbar davon aus, dass damit das Problem gelöst sei. WIR im lächerlich unbedeutenden Deutschland haben Abstand davon genommen (soweit offiziell bekannt), andere Länder keineswegs. Das gilt ebenso für die Entwicklung von Massenvernichtungswaffen, autonomen Waffensystemen etc. Nur weil unsere Bananenrepublik, inkompetent verwaltet und überreguliert, etwas nicht tut, hat das leider keinerlei Einfluss auf den Rest der Welt.

Und genau da liegt die Crux: Wenn "WIR" uns entscheiden würden, die KI-Technologie nicht über ein gewisses Maß hinaus zu entwickeln, würde das Russland, China, Nordkorea... davon abhalten? Im Gegenteil, es würde diesen Ländern einen nicht aufzuholenden Vorsprung verschaffen, während wir selbst uns Handlungsoptionen nehmen. Ein Blick in die Geschichte zeigt, dass so etwas noch nie funktioniert hat.

Keine KI kann die Menschheit existenziell bedrohen oder sie gar ausrotten. Menschen können das, ggf. mit Hilfe von KI-Systemen. Diese sind dann aber nur ein (wenn auch sehr mächtiges) Werkzeug, nicht mehr und nicht weniger.

Ausschlaggebend wird sein, wieviel Beeinflussungsmöglichkeiten der realen, physischen Welt, wir KI-Systemen anvertrauen. Keine KI kann ein Ventil öffnen, einen Virus freisetzen oder Atomreaktoren zur Explosion bringen, wenn wir uns nicht entscheiden, ihr die physischen Möglichkeiten zu geben. Dieser Punkt sollte - im Rahmen des Möglichen - reglementiert werden.

Eine weltweite Entwicklung mit enormem wirtschaftlichem Potentenzial ist nicht zu stoppen, und mit Hollywood-Unterhaltung als "Mahnung" zu argumentieren ist absurd. Oder welchen Rat gibst Du Deinen Kindern? Keine Klingonen ins Haus zu lassen? Es sollte bessere Argumente geben, denke ich.

Bis jetzt ist mir kein plausibles Szenario bekannt, nach dem allein eine KI die Menschheit existenziell bedrohen könnte. Soziale Umbrüche, auch dramatisch, wird es geben. Die gab es schon immer und die Menschen sind extrem gut darin, sich an neue Umstände anzupassen. Diese Untergangsszenarien erinnern mich fatal an Geschichten diverser Sekten/Religionen, die daraus einen Macht- und Überlegenheitsansprüchen gegenüber den "Ungläubigen" abgeleitet und mehr Schaden angerichtet haben, als es eine KI jemals könnte.

MENSCHEN sind das Problem, nicht die KI. Und evtl. können MENSCHEN auch die Lösung sein. Panikmache schürt nur irrationales Verhalten und hilft niemandem.

Grüße

Matthias

Karl Olsberg (Mittwoch, 22 Mai 2024 08:37)

@Matthias: Danke für deinen Kommentar und die klare Darstellung deines Standpunkts. Allerdings bin ich in fast allen Punkten anderer Meinung. Wir können natürlich hier in Deutschland nicht das Denken der Menschen in anderen Ländern verändern, aber wir können zumindest damit anfangen, das Problem hier ernst zu nehmen und es nicht weiter (so wie du) als "Panikmache" und "Hollywood-Unterhaltung" abzutun.

Dass du mir nicht glaubst, dass das Problem ernst ist, kann ich nachvollziehen. Aber du solltest die Warnungen der führenden KI Forscher der Welt ernst nehmen: https://www.tagesspiegel.de/wissen/verlust-der-kontrolle-uber-ki-forschende-warnen-vor-extremen-risiken-11687462.html und vielleicht mehr hinterfragen, wieso sie glauben, dass das ein reales Problem ist (hier dazu meine Sicht: https://www.ki-risiken.de/2024/05/21/wieso-ist-ki-eine-existenzielle-bedrohung/) Ich gebe dir Recht: Das eigentliche Problem ist nicht KI, sondern menschliche Dummheit. Aber die Dummheit besteht (unter anderem) darin, eine KI zu entwickeln, die wir nicht mehr kontrollieren können. Und diese Gefahr ist leider sehr real, so sehr ich auch wünschte, du hättest recht und ich würde hier bloß Panikmache verbreiten.

Henrik (Mittwoch, 22 Mai 2024 14:19)

Ich kann beide obigen Standpunkte und Sichtweisen sehr gut verstehen, sie bieten parallel nebeneinander existierende Wahrheiten. Einerseits kann man mit der "German Angst" und Bedenkenträgerei alles soweit katastrophisieren, dass nur noch Paralyse und Stagnation daraus resultieren - Stichwort Überregulierung. Es stimmt auch, dass wir den Geist nicht wieder in die Flasche kriegen - wenn ein unfassbar mächtiges Werkzeug hergestellt werden kann - wird es jemand tun und sich einbilden, diese unfassbare Macht kontrollieren und zu seinem Vorteil einsetzen zu können - Stichwort Dummheit.

Das hätte schon fast etwas humoristisches, wenn eine verzweifelt um absolute Kontrolle bemühte Macht wie China in dem Bemühen, diese Kontrolle noch umfassender zu machen, eine KI entwickelt, die es nicht mehr kontrollieren kann - insofern wird man in der Partei durchaus auch auf diesen Gedanken gekommen sein. Aber nützen wird das nicht, egal wie berechtigt die Mahner Bedenken äußern - die KI Entwicklung wird voranschreiten.

Insofern sind alle geäußerten strategischen Punkte nützlich, meiner Meinung sogar notwendig, werden aber die Entwicklung nicht aufhalten. Insofern halte ich eine parallel anzudenkende Strategie für unabdingbar - wie gehen wir vor, wenn eine solche KI entstanden ist und mit welchen Maßnahmen halten wir sie auf, wenn das Kind in den Brunnen gefallen ist und Anpassung nicht mehr wünschenswert erscheint.

Sollten wir das nicht schaffen werden wir die zweitintelligenteste Rasse sein - und da braucht man wirklich keine Science Fiction Werke zu bemühen um klar zu interpolieren, wie es einer solchen Rasse ergeht - sie wird genutzt, um den Zielen der intelligentesten Rasse zu dienen. Alles andere anzunehmen wäre dann schon wieder Dummheit.

Karl Olsberg (Mittwoch, 22 Mai 2024 20:18)

@Henrik: Wenn das Kind in den Brunnen gefallen ist, sind wir höchstwahrscheinlich alle tot. Wir werden nicht die "zweitintelligenteste" Rasse sein, denn eine KI hat anders als wir kein natürliches Bedürfnis nach "Natur" und auch keine angeborene Sympathie für andere Lebewesen. Die KI braucht uns auch nicht als Arbeitskräfte, jedenfalls nach kurzer Zeit nicht mehr. Sie ist wie eine Alien-Rasse, die die Erde in Besitz nimmt und nach ihren Bedürfnissen umgestaltet. Wir haben dabei keinen Platz. Deshalb gibt es für mich nicht die Option, uns auf diese Situation einzustellen. Wir müssen sie verhindern, egal wie schwierig das ist.

Marco Lachmann-Anke (Samstag, 25 Mai 2024 07:21)

OMG wir werden alle sterben �

Spaß beiseite: das “KI-ausser-Kontrolle” Problem (falls es eins ist) ist nicht vom Menschen lösbar.

Schon weil alles was schief gehen kann, auch schief gehen wird: Murphys Gesetz

Also brauchen wir uns keine Sorgen machen, denn es liegt eh nicht in unserer Hand.

Wenn es schief geht, ok.

Wenn nicht, ok.

In beiden fällen müssen wir (wie immer) das beste daraus machen.

Aber die Angst davor, die können wir kontrollieren. Angst ist eine Entscheidung.

Also entscheiden wir uns einfach Dankbar zu sein, dann hat die Angst keine Chance �

Karl Olsberg (Samstag, 25 Mai 2024 11:14)

@Marco Lachmann-Anke: Es ist kein gottgegebenes Schicksal, sondern eine menschliche Entscheidung, ob wir eine potenziell unkontrollierbare KI bauen. Sich keine Sorgen zu machen, weil man angeblich eh nichts tun kann, ist da die denkbar schlechteste Strategie. Natürlich sollte man deswegen nicht aufhören, Spaß am Leben zu haben, und nicht jeder muss sich diesem Thema voll und ganz verschreiben. Aber den Kopf in den Sand zu stecken hilft am allerwenigsten.

Ich betreibe diese Aufklärungsarbeit nicht aus Angst um mich selbst, sondern aus Sorge um die Zukunft meiner drei Söhne und ihrer ganzen Generation. Ich sehe es als meine Pflicht an, darüber zu informieren, dass es ein existenzielles Risiko der KI gibt, denn nur, wenn wir ein breites Verständnis dieser Tatsache haben, gibt es auch nur den Hauch einer Chance, etwas dagegen zu unternehmen. Deshalb macht mich dieser in den letzten Tagen hundertfach gehörte Fatalismus "wir können eh nichts tun" betroffen und traurig, auch wenn ich ihn ein Stück weit verstehen kann.

Ria (Samstag, 25 Mai 2024 23:33)

Meine bescheidene Laien-Meinung dazu: echte physische Macht kann KI nur dann entfalten, wenn sie 1. Menschen dazu missbraucht, ihre Handlungswünsche auszuführen oder 2. von uns Macht über unsere physische Welt eingeräumt bekommt (z.B. über von ihr kontrollierte Roboter).

Das hieße für mich konkret: KI dürfte nur von dazu befugten Personen genutzt werden, welche gleichzeitig einem Kontrollgremium unterstehen, das diese KI nicht nutzt. Des Weiteren müsste bautechnisch/hardwaretechnisch gewährleistet sein, dass KI nicht eigenständig Zugang zu anderen Netzwerken erlangen kann. Ich bin mir nicht sicher, ob das alles in unserer heutigen Welt überhaupt noch durchsetzbar wäre...

Ria (Samstag, 25 Mai 2024 23:39)

Noch eine Überlegung: Kann man eine KI durch eine andere, nur für diesen Zweck entwickelte KI, kontrollieren lassen? Könnte man solche Kontrollmodelle evtl. auf ihre Wirksamkeit hinsichtlich all dieser Faktoren wie Superalignment usw simulieren und testen?

Karl Olsberg (Sonntag, 26 Mai 2024 11:54)

@Ria: "KI dürfte nur von dazu befugten Personen genutzt werden, welche gleichzeitig einem Kontrollgremium unterstehen, das diese KI nicht nutzt. " Das ist eine interessante Idee, aber sie wird nicht ausreichen, um die KI daran zu hindern, auch das Kontrollgremium zu manipulieren. Denn das kann sie ja auch indirekt tun, indem sie der direkt mit ihr interagierenden Person sagt, was sie dem Kontrollgremium sagen soll, oder dies subtil beeinflusst.

"Kann man eine KI durch eine andere, nur für diesen Zweck entwickelte KI, kontrollieren lassen?" Das ist prinzipiell die Idee hinter Superalignment von OpenAI. Der Haken ist: Entweder ist die Kontroll-KI intelligenter als wir, dann haben wir dasselbe Problem wie bei der zu kontrollierenden KI - wir wissen nicht, was sie warum tut und ob sie uns wirklich hilft oder ihre eigenen Ziele verfolgt. Oder sie ist nicht intelligenter, dann hat die Kontroll-KI dasselbe Problem wie wir: Wie kontrolliert man etwas, das intelligenter ist als man selbst? Das soll nicht heißen, das KI-basierte Ansätze nicht hilfreich sein können. Aber sie lösen das Problem nicht wirklich.